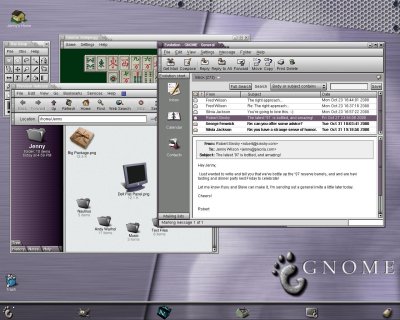

Der in Tokio entwickelte Isamu-Roboter läuft mit RTLinux, dem Linux für Echtzeit-Anwendungen.

Die vorliegende Version des Textes unterscheidet sich von der bei Telepolis veröffentlichten Variante. Alle Teile wurden auf einer Seite zusammengefasst. Die Bilder sind größer und in besserer Qualität. Einige Tipp- und Stilfehler wurden korrigiert. Sollten Sie auf Fehler im Text stoßen, schicken Sie mir bitte eine Mail. Inhaltliche Ergänzungen oder Aktualisierungen beabsichtige ich jedoch nicht vorzunehmen.

Teil 1: Die Befreiung von Unix

Der in Tokio entwickelte Isamu-Roboter läuft mit RTLinux, dem Linux für Echtzeit-Anwendungen. |

Das Projekt Linux begann mehr oder weniger offiziell am 25. August 1991 mit einer Mitteilung in einer Newsgroup. Das Usenet ist ein dezentrales Diskussionsnetz, das in Gruppen unterteilt ist. News-Server synchronisieren gegenseitig den Bestand einzelner Diskussionsgruppen. Ein Beitrag (Posting) in einer Newsgroup ist damit innerhalb von Sekunden auf Hunderten von Servern auf der ganzen Welt verfügbar (siehe Schöner Tauschen IV für eine kurze Einführung). Redundanz erhöht die Zuverlässigkeit, und so funktionierte das Usenet auch an jenem Tag, als der Finne Linus Torvalds einen berühmt gewordenen Beitrag in die Gruppe "comp.os.minix" postete [1]:

Von: torvalds@klaava.Helsinki.FI (Linus Benedict Torvalds)Um diese Anfrage entziffern zu können, muss man ein wenig über Unix wissen. Um die Programmierung von großen Rechenanlagen zu erleichtern und zu standardisieren, entwickelte ein Team von Informatikern an den Bell Laboratories (Bell war bis zur staatlich erzwungenen Aufspaltung 1984 das Telefonmonopol der USA) ein Betriebssystem namens Unix, das bis heute - natürlich in stark veränderter Form, aber mit einer prinzipiell ähnlichen Architektur - den Standard auf Großrechnern setzt.

Newsgroups: comp.os.minix

Betreff: Was würdet Ihr am liebsten in Minix sehen?

Zusammenfassung: kleine Umfrage für mein neues Betriebssystem

Nachrichten-ID: <1991Aug25.205708.9541@klaava.Helsinki.FI>

Datum: 25. August 1991 20:57:08 GMT

Organisation: Universität von HelsinkiHallo an alle da draußen, die minix benutzen -

Ich entwickle ein (freies) Betriebssystem (nur ein Hobby, wird nicht professionell und groß sein wie gnu) für 386er (486er) AT Clones. Das läuft jetzt etwa seit april und fängt langsam an, fertig zu werden. Ich hätte gerne Rückmeldung darüber, was Ihr an minix mögt oder weniger mögt, da mein Betriebssystem etwas daran erinnert (gleiches physikalisches Layout des Dateisystems (aus praktischen Gründen) neben anderen Dingen). Ich habe zur Zeit bash(1.08) und gcc(1.40) portiert, und es scheint zu funktionieren. Ich werde also in den nächsten Monaten etwas Brauchbares ans Laufen bekommen, und ich wüsste gerne, welche Funktionen Ihr gerne drin hättet. Alle Vorschläge sind willkommen, aber ich verspreche nicht, dass ich sie auch implementiere :-)

Linus (torvalds@kruuna.helsinki.fi)

PS: Ja - kein minix Code ist enthalten, und es hat ein multi-threaded Dateisystem. Es ist NICHT portabel (verwendet 386er-Taskwechsel etc), und es wird wahrscheinlich nie etwas anderes unterstützen als AT-Festplatten, weil das alles ist, was ich habe :-(.

Von allen Programmen, die auf einem Computer laufen, ist das Betriebssystem das grundlegendste. Es stellt Basisfunktionen für die Ein- und Ausgabe von Daten bereit, steuert Geräte an und verwaltet die laufenden Programme. Das Betriebssystem sorgt auch dafür, dass mehrere Programme gleichzeitig laufen können, indem es einzelnen Programmen jeweils Prioritäten zuweist und je nach Priorität einen unterschiedlichen Anteil an der Rechenzeit zuteilt (man spricht hierbei auch von Prozessen - ein Prozess ist eine "Instanz" eines Programms, das ja durchaus auch mehrfach aufgerufen werden kann).

Als Unix 1974 das erste Mal in einem Paper beschrieben wurde, hatte es bereits diese als Multitasking bekannte Fähigkeit (der Name Unix leitet sich von seinem gescheiterten Vorgänger Multics ab). Unix konnte außerdem mit mehreren Nutzern auf einem Rechner umgehen: Jeder Nutzer hat ein "Heimatverzeichnis", in dem seine Dateien liegen, und kann nicht auf die Dateien anderer Nutzer zugreifen. In einer Welt, in der sich viele Menschen einen Großrechner teilen mussten, war sowohl Multitasking- als auch Multiuser-Fähigkeit ein Muss. Man konnte beliebige Programme installieren und schreiben, die, ggf. mit geringen Veränderungen, auch auf anderen Unix-Systemen lauffähig waren.

Dennis Ritchie und Ken Thompson von den Bell Labs portieren das Betriebssystem Unix auf einen PDP-11 Großrechner |

Unix war ein kommerzielles Projekt, das durch Copyrights, Markenrechte und Patente "geschützt" wurde. Der Monopolist Bell/AT&T wurde aber aus Antitrust-Gründen bereits 1956 dazu gezwungen, alle seine Patente an interessierte Parteien zu lizenzieren. [2] Nur so konnten Derivate von Unix überhaupt entstehen, und Unix konnte sich als Standardplattform etablieren. Mit anderen Worten: Die Abwesenheit des überlicherweise durch Patente gewährten Monopolrechts führte zu einer drastischen Steigerung des Wettbewerbs, der Innovation und der Standardisierung. Die US-Justiz hatte ja bereits Erfahrungen mit Bell: Im 19. Jahrhundert hatte "Ma Bell" durch Patente jede Konkurrenz erstickt. Als die schließlich 1893 und 1894 ausliefen, gründeten sich über 6000 unabängige Telefonfirmen in den USA. [3]

Was ist GNU?

Obwohl Unix zunehmend zur Standardplattform wurde, waren die existierenden Varianten immer noch durch Schutzrechte in ihrer Verwendung eingeschränkt - AT&T verlangte Lizenzgebühren für jedes installierte Unix und für Unix-Derivate. Das dürfte ein Hauptgrund sein, warum Unix heute nicht den Standard auf PCs bildet. Denn Microsoft entwickelte als Alternative zu dem extrem primitiven DOS ein eigenes Unix, Microsoft Xenix. Für die PC-Plattform wurde jedoch DOS (und später das darauf aufsetzende Windows) bevorzugt, wohl vor allem, so wurde gemutmaßt, aus Lizenzgründen. Windows wurde der Standard, Xenix an Entwicklerfirma SCO verkauft, die heute zu Caldera gehört.

Programme für Unix wurden häufig nur in Binärform weitergegeben. Das bedeutet, dass es nicht möglich war, sie zu verändern - die "binäre" (aus Einsen und Nullen bestehende) Computersprache kann von Menschen kaum noch nachvollzogen werden (selbst wenn man sie in Instruktionen und Parameter zerlegt), weshalb es eine Vielzahl von Programmiersprachen gibt, die nach dem Schreiben oder während der Ausführung in Maschinencode übersetzt werden. Wenn der Quellcode also überhaupt verfügbar war, dann meist nur unter einer Lizenz, die Weitergabe und Veränderungen einschränkte.

1983 hatte Richard Stallman, Forscher in der Abteilung für Künstliche Intelligenz des renommierten MIT, genug von den Beschränkungen, denen das Unix-Betriebssystem und die dazugehörigen Programme unterlagen. Als er 1971 am MIT anfing, wurde dort ausschließlich freie Software eingesetzt: Man konnte sie für alle Zwecke einsetzen, verändern und weitergeben. Doch mit Unix waren diese Freiheiten verschwunden. Stallman rief also zur Befreiung von Unix auf. Das neue Projekt trug den Namen GNU, eine rekursive Abkürzung für "GNU ist nicht Unix" (der erste Buchstabe steht wohl deshalb dort, weil er der einzige einsetzbare ist, der ein reales Wort ergibt).

Nach und nach kamen die einzelnen Bestandteile des freien Betriebssystems zusammen: ein Compiler für die Programmiersprache C, die dazugehörigen Bibliotheken mit Standardprogrammfunktionen, der mächtige Editor emacs, der Kommandozeilen-Interpreter bash usw. (eine vollständige Liste der offiziell zum GNU-Projekt gehörenden Programme findet sich hier). Stallman gründete die "Free Software Foundation", die freie Programme unter ihre Fittiche nimmt, rechtlichen Beistand erteilt und Medien informiert.

Aus GNU wird GNU/Linux

Was dem GNU-Projekt jedoch bis heute fehlt ist der Kernel, der die Systemhardware Programmen zugänglich macht. Seit ca. 1990 bemüht man sich darum, das GNU-Betriebssystem mit einem eigenen Kernel namens Hurd zu vervollständigen. 1991 entwickelte der finnische Student Linus Torvalds schließlich, inspiriert durch das experimentelle PC-Unix Minix, wie oben erwähnt, seinen eigenen Kernel, den er Linux nannte. Torvalds entschied sich, den Code frei zur Verfügung zu stellen, und dank des damals an vielen Universitäten bereits vorhandenen Internet erfuhren schnell Tausende von Interessierten davon.

Für Hurd gab es zu diesem Zeitpunkt kaum noch Hoffnung, auf absehbare Zeit fertig zu werden - so liefen die Entwickler in Heerscharen zu Linux über und bereicherten den Kernel um Treiber, Dateisysteme und weitere grundlegende Funktionen. Doch Linux wäre wertlos gewesen, hätte es zu diesem Zeitpunkt nicht die riesige GNU-Toolsammlung gegeben - dank des freien C-Compilers gcc, der Teil des GNU-Projekts ist, konnten z.B. sofort Programme für Linux entwickelt werden.

Richard Stallman und Linus Torvalds: Das Verhältnis zwischen den GNU/Linux-Visionären ist gestört |

Als Linux und Linus bekannt wurden, erhielten Richard Stallman und das GNU-Projekt kaum die ihnen gebührende Wertschätzung. Stallman besteht deshalb seit einiger Zeit darauf, dass man nicht von Linux, sondern von GNU/Linux sprechen soll. Doch der holprige Name konnte sich bislang nicht exklusiv durchsetzen, was sicher auch mit Stallmans legendärer Sturheit zu tun hat, die viele Entwickler abschreckte. Ganz im Sinne der Konkurrenz kam es zu Grabenkämpfen innerhalb des Linux-Lagers bis hin zu Boykottaufrufen gegen GNU.

Software soll frei sein

Alle GNU-Programme werden unter eine spezielle Lizenz gestellt, die "GNU General Public License" ( GPL) für Programme mit offenem Quellcode. Auch der Linux-Kernel und viele weitere Programme stehen unter der GPL, ohne jedoch offizieller Bestandteil des GNU-Projekts zu sein (was auch eine Verwaltung des Copyrights durch die "Free Software Foundation" einschließen würde - wenn es dann rechtliche Probleme gibt, springt die FSF ein).

Die GPL erlaubt im Wesentlichen die beliebige Verwendung der entsprechend lizenzierten Programme, verbietet es jedoch, das Programm oder Ableitungen davon in Umlauf zu bringen, ohne wiederum den Quellcode unter den Bedingungen der GPL freizugeben. Wer also GPL-Programme verbessert, muss diese Verbesserungen wiederum der Community von Nutzern zur Verfügung stellen. So soll Software "frei" bleiben von den sonst üblichen Zwängen des Urheberrechts - Closed-Source-Software nennt man dagegen auch "proprietär" (in exklusivem Besitz).

Neben der GPL gibt es noch andere Lizenzen für Open-Source-Software, die sich insbesondere in Hinblick auf die Verpflichtung zur Freigabe des Quellcodes bei Veränderungen und die Einschränkung der direkten Verknüpfung mit proprietären Programmen beziehen (Übersicht). Die Präferenzen der Entwickler sind stark unterschiedlich und hängen von den jeweiligen ideologischen Vorstellungen ab: Soll alle Software frei sein, oder soll es eine pragmatische Mischlösung geben?

Die GPL spielte auch eine Rolle in einem Propagandafeldzug Microsofts gegen Open-Source-Software. Es begann mit einem Vortrag des Microsoft-Vizepräsidenten Craig Mundie im Mai an einer Wirtschaftshochschule, in dem er die GPL als "viral" bezeichnete und damit einen Begriff prägte, den Microsoft noch weiter einsetzen sollte. Durch die Lizenz werde das geistige Eigentum von Firmen infiziert, da jede Software, die GPL-Code implementiere, ebenfalls unter die GPL gestellt werden müsse. "Diese virale Eigenschaft der GPL stellt eine Bedrohung des Eigentums jeder Organisation dar, die von ihr Gebrauch macht."

Während diese Aussagen vor allem irreführend waren (und die Assoziation von GNU/Linux mit Viren sicher kein Zufall), greift Microsoft zur Verteufelung von GNU/Linux auch auf glatte Lügen zurück: In einem Interview mit der Chicago Sun Times sagte Microsoft-Chef Steve Ballmer:

"Wir haben ein Problem damit, wenn die Regierung Open-Source-Software unterstützt. Von der Regierung unterstützte Software sollte für jedermann verfügbar sein. Open-Source-Software ist nicht für kommerzielle Unternehmen verfügbar. So, wie die Lizenz formuliert ist, muss man, wenn man beliebige Open-Source-Software benutzt, den Quellcode seiner gesamten Programme veröffentlichen. (..) Linux ist ein Krebsgeschwür, das im Sinne geistigen Eigentums alles infiziert, was es berührt."

In der GPL heißt es dagegen ausdrücklich: "Ferner bringt ein einfaches Zusammenstellen eines anderen Werkes, das nicht auf dem Programm basiert, zusammen mit dem Programm oder einem auf dem Programm basierenden Werk auf ein- und demselben Speicher- oder Vertriebsmedium das andere Werk nicht in den Anwendungsbereich dieser Lizenz." Die Zusammenstellung von freier Software mit proprietärer ist also völlig legal. Auch die kommerzielle Verwertung von GPL-Programmen wird implizit erlaubt. Es ist nicht notwendig, private Weiterentwicklungen von GPL-Programmen zu veröffentlichen - nur wenn man Programme, die GPL-Code beinhalten, veröffentlicht, muss man den gesamten Code freigeben. Darüber hinaus stehen viele Linux-Anwendungen gar nicht unter der GPL.

Entwicklungsprinzipien freier Software

Das Wachstum von GNU/Linux hat viele Beobachter überrascht. Innerhalb weniger Jahre wuchs das Betriebssystem um (fast) alle Funktionen, Treiber und Programme, die ein modernes System auszeichnen -- und ein Großteil dieser Software wurde wiederum anderen Entwicklern kostenlos und im Quellcode zur Verfügung gestellt. Von Anfang an beruhte die Linux-Entwicklung auf der häufigen Kommunikation aller Beteiligten über das Internet. Weltweit ist die Linux-Community heute wohl die am besten vernetzte Entwicklergemeinde überhaupt. Praktisch jeder Entwickler einer Systemkomponente ist per Email erreichbar - man versuche im Gegensatz dazu zum Vergleich einmal, auch nur dem Entwickler des Windows-Taschenrechners zu erreichen.

Das "Closed Source" Modell von Windows ähnelt den sozialen Verhältnissen des Mittelalters. Mönche (Microsoft-Entwickler) bereiten die Wahrheit auf, Priester (Marketingstrategen) reduzieren sie nach Kriterien der Verbreitbarkeit und Unantastbarkeit des kirchlichen Monopols, und das gemeine Volk hat sie unkritisch aufzunehmen - eine andere Wahrheit neben dem Monopol ist nicht zulässig und wird mit allen möglichen Mitteln bekämpft. Die GNU/Linux-Entwicklergemeinde ähnelt funktional eher studentischen Diskussionszirkeln oder ehrenamtlichen Vereinen: Am gemeinsamen Ziel mitwirken kann grundsätzlich jeder, der dazu willens und in der Lage ist.

Machtausübung oder das Streben nach Profit spielen eine untergeordnete Rolle. Im Gegenteil: Die Linux-Entwickler erfreuen sich daran, anderen Menschen etwas geben zu können. Das dürfte ein Hauptgrund sein, warum Linux aus ökonomischer Sicht auf viele Betrachter die gleiche Wirkung hat wie ein lila Elefant, der auf einem Hügel aus Marzipan steht und einer Erklärung harrt. Nach den klassischen Modellen handelt der Linux-Entwickler entgegen seinem "rationalen Eigeninteresse", da er eine Entwicklung, die er genauso gut zu Profitzwecken vermarkten könnte, lieber zum Nutzen der Allgemeinheit freigibt.

Was also ist die Motivation der GNU/Linux-Entwickler? GNU-Gründervater Richard Stallman beschreibt die möglichen Motivationsfaktoren wie folgt:

Es wird schnell klar, dass die Kommunikation mit den Nutzern eine entscheidende Rolle für die weitere Entwicklung spielt. Da ist zum einen das einfache "Dankeschön", das bei so vielen ehrenamtlichen Tätigkeiten für das Weitermachen entscheidend ist. Bei freier Software, die für den Eigenbedarf entwickelt wird, kommt hinzu, dass man nur dann von den intellektuellen Leistungen der Nutzer profitieren kann, wenn man den Quellcode der Software freigibt: So dient die Freigabe des Quellcodes auch dem ökonomischen Eigeninteresse.

Schwierig ist es, die Wichtigkeit von Altruismus als Motivationsfaktor zu definieren. Mam könnte auch argumentieren, dass letztlich jedes Handeln der Befriedigung von eigenen Bedürfnissen dient und damit egoistisch ist - schließlich steht hinter altruistischen Handlungen oft die Erwartung der Erwiderung des Gefallens oder zumindest des Dankes. Doch wenn jedes Handeln egoistisch ist, ist das Wort Egoismus unsinnig. Altruistisch ist demnach solches Handeln, dem kein konkretes Eigeninteresse gegenübersteht -- und das spielt wohl für einen Großteil der Open-Source-Entwicklung eine wesentliche Rolle.

Freie Software unter Windows

Auch unter Windows existiert freie Software, teilweise portiert von Linux oder exklusiv unter der GPL für Windows entwickelt, wobei zur Entwicklung oder Portierung oft wiederum die portierten Compiler und Interpreter eingesetzt werden. Doch die Mehrzahl der Programme ist nicht im Quellcode verfügbar. Dabei wäre es unter Windows prinzipiell wie unter Linux möglich, viele Programme offen zu entwickeln. Warum geschieht es dann nicht häufiger?

Ursächlich dafür ist zum einen die simple Tatsache, dass ein Windows-Betriebssystem nach der Installation nicht programmierbar ist. Das Betriebssystem enthält keinerlei Werkzeuge, um über kleine Skript-Spielereien (Dateien löschen, "ILOVEYOU" an alle Freunde im Outlook-Adressbuch verschicken etc.) hinausgehend Programme zu entwickeln. Microsoft bietet die entsprechenden Entwicklungswerkzeuge separat an. Visual Basic kostet für Schüler rund 100 Euro, die Profi-Version des Entwicklungstools Visual C++ kostet ca. 700 Euro. Wer also freie Software für Windows entwickeln will, muss zunächst einmal Geld ausgeben.

Bei der normalen Benutzung seines Betriebssystems wird der Nutzer aber zum Kauf eines Entwicklungstools nie veranlasst: Da ja alle Programme ohnehin nur in binärer Form vorliegen, muss der Windows-User zu keinem Zeitpunkt lernen, mit einem Compiler umzugehen, um Quellcode in ausführbare Programme zu übersetzen - und selbst wenn er es wollte, er kann es bei den Standardprogrammen nicht tun.

Hinzu kommt, dass die Windows-Programmierung durch oft unlogische Schnittstellen (APIs) erschwert wird - an diese Schnittstellen muss man sich aber halten, wenn die eigenen Programme im Betriebssystem wie andere funktionieren sollen. Aus Gründen der ewigen Abwärtskompatibilität enthalten viele APIs noch unnötige Überbleibsel aus frühren Zeiten - die man aber lernen muss, um Windows programmieren zu können. Als Windows-Entwickler ist man also wie der Mönch im Mittelalter in das Weltbild Microsofts eingebunden, und hat praktisch keine Möglichkeit, es aktiv zu verändern. Die Abwärtskompatibilität ist aber nur deshalb so wichtig, weil man keine Möglichkeit hat, ein altes Programm, das vielleicht wegen einer Zeile Code nicht mehr funktioniert, anzupassen - denn der Code liegt meist nicht vor.

Während Unix-Systeme sich um Interoperabilität bemühen, Programme also mit wenig Aufwand von einem Unix zu einem anderen portiert werden können, ist Windows eine Sackgasse: Wer für die Windows-APIs entwickelt, kommt so schnell nirgendwo anders hin, schließlich liegt der Quellcode der Windows-Bibliotheken nicht offen. Selbst IBM entschied sich deshalb, den Code von Windows für sein gescheitertes Betriebssystem OS/2 zu lizenzieren. Wenn ein Windows-Programm auf mehreren Plattformen läuft, ist das meist der Open-Source-Community zu verdanken, die mit WINE mühselig seit Jahren an einer von Grund auf selbst geschriebenen Windows-Emulation arbeitet. (Daneben gibt es noch Hardware-Emulatoren, die einen "PC im PC" erzeugen, innerhalb dessen dann beliebige Software installiert werden kann, unter anderem eben auch Windows samt Software.)

Learning By Doing

Software-Entwicklung lernt man am besten anhand komplexer Beispiele -- doch wenn diese nur in geringer Zahl existieren, hilft nur der Kauf von Literatur. Während die Linux-Community mit freien Dokumenten und viel Rat und Tat zur Seite steht, ist man unter Windows häufig auf den Kauf zusätzlicher Referenzwerke angewiesen, was auf Dauer noch einmal mit Hunderten von Euro zu Buche schlagen kann. Oft ist es aus Lizenzgründen gar nicht möglich, den Quellcode von Windows-Programmen freizugeben: Wenn diese nämlich lizenzierte Komponenten dritter Hersteller behinhalten, die nur in Binärform vorliegen -- was besonders bei aufwendigen grafischen Oberflächen schnell der Fall sein kann.

Die Windows-Kultur behandelt somit die Mehrzahl der Nutzer wie TV-Konsumenten (um einmal die Analogie zu wechseln), die an der Programmgestaltung nicht mitwirken, sondern nur die Programme anderer konsumieren sollen. Praktisch für Microsoft & Co.: So besteht keine Gefahr, dass aus den Reihen der Nutzerschaft ernsthafte Konkurrenz zu den kommerziellen Lösungen der Großanbieter entsteht. Die Motivation für Entwickler, den Quellcode ihrer Programme freizugeben, ist gering: Sie müssen die höheren Kosten der Entwicklung decken, und die Mehrzahl der Nutzer verfügt ohnehin nicht über die Werkzeuge oder das Wissen, um selbst etwas zur Entwicklung beizusteuern. Statt Lob wird der Open-Source-Entwickler unter Windows Häme und Beschwerden ernten, wenn er sein Programm nicht in einer einfach zu installierenden Binärvariante bereitstellt.

Hochgeschwindigkeits-Entwicklung

"Die Fähigkeit von Open-Source-Entwicklung, die gemeinsame Intelligenz Tausender Entwickler aus dem Internet zu sammeln und nutzbar zu machen, ist einfach unglaublich." Dies sagte nicht etwa Richard Stallman oder Linus Torvalds, es ist vielmehr einem internen Strategiepapier Microsofts entnommen, dem sogenannten Halloween Document I, das im Herbst 1998 an die Öffentlichkeit gelangte. "Was noch wichtiger ist, Open-Source-Evangelisierung wächst gemeinsam mit der Größe des Internet viel schneller als unsere eigenen Envangelisierungs-Bestrebungen", fährt das Dokument fort.

Tatsächlich scheint der hohe Vernetzungsgrad der Open-Source-Entwickler eine wesentliche Rolle für die Geschwindigkeit sowohl der Entwicklung als auch der Verbreitung von Open-Source-Software zu spielen. In seinem bekannten Essay Die Kathedrale und der Basar bemüht sich Eric Raymond, das Open-Source-Phänomen zu erklären. "Die Anwender als Mit-Entwickler zu sehen ist der Weg zu schnellen Verbesserungen und Fehlerbehebungen, der die geringsten Umstände macht", schreibt Raymond.

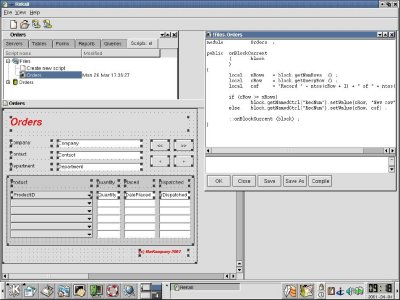

Viele Open-Source-Programme werden gar nicht als Binärversionen angeboten, sondern nur im Quellcode: Ein potenzieller Nutzer muss das Programm erst kompilieren (was im Regelfall sehr einfach ist). So wird auch die Schwelle reduziert, gegebenenfalls selbst Veränderungen vorzunehmen, da man ja bereits weiß, wie man aus dem veränderten Code wieder eine lauffähige Version macht. Viele OSS-Projekte nutzen sogenannte CVS-Server. Damit lässt sich ein Projekt effizient von mehreren Entwicklern bearbeiten, Veränderungen durch andere können einfach sichtbar gemacht und Kollisionen bei der gemeinsamen Entwicklung leichter verhindert werden.

Der derzeit noch kostenlose Dienstleister SourceForge bietet Open-Source-Projekten ein Zuhause. Das beinhaltet nicht nur Speicherplatz und Bandbreite, sondern auch CVS-Funktionen, die Überwachung und Verwaltung von Fehlern und Vorschlägen, Diskussionsforen und Mailing-Listen, Aufgabenverwaltung, Dokumentmanagement und vieles mehr. SourceForge-Nutzer haben eindeutige Nutzernamen und können sich gegenseitig mit Bewertungen versehen, so dass z.B. Benutzer mit besonders guter Teamfähigkeit oder besonders großen technischen Fähigkeiten schnell erkannt werden können. Das System bietet eine direkte Kommunikationsschnittstelle für Entwickler und Nutzer gleichermaßen, so dass jeder an der Optimierung eines Programms mitwirken kann. Die Software von SourceForge, Alexandria, steht selbst unter der GPL und wird z.B. von dem öffentlich und privat geförderten deutschen Pendant BerliOS genutzt.

Damit Open-Source-Projekte auch auf anderen Betriebssystemen als auf Linux problemlos laufen, bietet SourceForge sogar kostenlos Zugang zu einer sogenannten "Compile-Farm": Man kann sich bei Rechnern mit anderen Betriebssystemen einloggen und prüfen, ob der eigene Code dort problemlos läuft. Das Non-Profit-Projekt OSDLab bietet Entwicklern außerdem die Möglichkeit, ihre Projekte auf größeren Rechneranlagen zu testen und so die Skalierbarkeit zu prüfen.

Diese kostenlosen Projekte machen Open-Source-Plattformen attraktiver und nützen damit allen, die mit diesen Systemen Geld verdienen wollen. Dennoch stellen sich viele Entwickler die Frage, wie lange solche Projekte noch existieren können.

Kritik an freier Software

Kritiker bemängeln, Open-Source-Entwicklung sei chaotisch: Es fehle an Management, Controlling und Marketing, zu selten würden definitive richtungsgebende Entscheidung getroffen. Tatsächlich kann ein Open-Source-Projekt genau wie ein Closed-Source-Projekt auf unterschiedliche Weise "gemanagt" werden. Wie Eric Raymond in seinem Essay Homesteading the Noosphere beschreibt, werden viele Open-Source-Projekte von einem "wohlwollenden Diktator" geleitet, der entscheidet, welche Veränderungen den Weg in die offizielle Version eines Programms finden. Je nach Projekt hat dieser Leiter einen unterschiedlich starken Einfluss, und manche Projekte werden demokratisch oder anarchistisch verwaltet: Es wird abgestimmt, oder jeder Autor hat die gesamte "Macht" über das Projekt, und Fehler werden von der Mehrzahl der Autoren letztlich gegenseitig ausgeglichen, ähnlich wie bei Wiki-Webs wie Wikipedia.

Welches dieser Modelle das "richtige" ist, hängt letztlich auch vom Projekttyp ab, woraus sich z.B. eine unterschiedlich große Zahl von Entwicklern, Häufigkeit von Veränderungen und Wichtigkeit schneller Veröffentlichung ergibt.

Kritiker merken weiterhin an, dass unzählige Open-Source-Projekte schlicht inaktiv bleiben - SourceForge ist voll von solchen "Projektleichen". Das hat mit mehreren Faktoren zu tun:

Fast alle diese Probleme - und einige spezifische - gelten in anderer Form auch für Closed-Source-Software. Der wesentliche Unterschied ist, dass sie bei Open-Source-Software offener sichtbar sind. Natürlich kann man aber auch für diese Probleme Lösungen erarbeiten.

Als Beispiel für Open-Source-Software von minderwertiger Qualität wird oft der Web-Browser Mozilla angeführt: Im Januar 1998 wurde der Code des Netscape-Browsers freigegeben und so eine offene Weiterentwicklung ermöglicht, in der Hoffnung, dem Beinahe-Browser-Monopolisten Microsoft auch ohne Mammut-Investments Paroli bieten zu können. Doch das Projekt war bislang ein Fehlschlag: Zwar verfügt Mozilla über exzellente Funktionalität und hält sich penibel an die Standards des W3C, doch Speicherbedarf, Geschwindigkeit und Stabilität lassen nach wie vor sehr zu wünschen übrig. So sehr, dass viele Stimmen (unter anderem das Online-Magazin Suck) gar forderten, das Projekt endlich zu begraben und neu anzufangen.

Mozilla und auch das von Sun freigegebene StarOffice unterscheiden sich jedoch von der meisten Open-Source-Software insofern, als dass der ursprüngliche Code nach dem traditionellen Closed-Source-Modell entwickelt wurde. Die Version von Mozilla, die den Open-Source-Hackern 1998 zur Verfügung gestellt wurde, war keineswegs identisch mit Netscape 4, den viele immer noch als Alternative zu IE benutzen. Vielmehr handelte es sich um eine interne Entwicklungsversion, die von Netscape als "nicht einmal Alpha" bezeichnet wurde - im Alpha-Stadium gilt eine Software als mit Sicherheit fehlerbehaftet, bis sie dann in der Beta-Phase zum Test freigegeben werden kann. Das Programm war so voller Bugs, dass sich die Entwickler entschieden, große Teile neu zu schreiben.

Dies geschah aber immer noch im Rahmen des von Netscape vorgegebenen Funktions-Frameworks, das ziemlich gigantisch war. Zu allem Überfluss scheinen aufgrund von Koordinationsproblemen immer mehr Funktionen hinzugefügt worden zu sein, während prinzipielle Fehler teils über Monate hinweg im Code verblieben. Eigens für die Verwaltung von Bugs und Vorschlägen wurde ein System namens Bugzilla entwickelt, das es unter anderem erlaubt, über die wichtigsten Fehler abzustimmen.

Da Bugzilla jedoch ein recht komplexes Interface verwendet und primär von Entwicklern genutzt wird, bleiben die meisten Bugs ohne Bewertung. Hier wären sicherlich Verbesserungen und eine größere Einbeziehung der Nutzer möglich. Denn wenn das Beseitigen wichtiger Fehler Entwicklern in der gesamten User-Community einen höheren Statusgewinn verschafft als das Hinzufügen hübscher neuer Features, könnte sich die Richtung der Entwicklung drastisch ändern.

Das eigentlich Erstaunliche an Mozilla ist, dass der Browser trotz allem stetig besser und stabiler geworden ist und trotz aller Kritik (die, wenn sie bösartig formuliert ist, für Freiwilligenprojekte oft tödlich sein kann) die Arbeit an dem Projekt emsig fortgesetzt wird. Während man es bei proprietärer Software oft erlebt, dass die nächste Version eines Programms deutlich schlechter ist als die vorherige, gilt es in der Open-Source-Gemeinde fast schon als selbstverständlich, dass ein neues Programmrelease besser sein muss als das vorherige. Das liegt nicht nur am Entwicklungsprozess, sondern auch an der stets gegebenen Möglichkeit, ein Programm zu "forken" (von engl. "fork", Gabel).

Wenn die neueste Version eines Programms nicht tut, was man will, und der Projektleiter Sturheit signalisiert, können sich andere Entwickler abspalten und das Projekt selbst weiterentwickeln. Da oftmals Nutzer und Entwickler identisch sind, ist die Motivation hierfür groß. Im Falle von Mozilla gibt es sowohl unter Windows als auch unter Linux Mozilla-Forks, die den Funktionsumfang des Browsers auf das Wesentliche reduzieren: K-Meleon und Galeon.

Was Open-Source-Projekten oft als Nachteil vorgehalten wird, nämlich die vielfach parallelen Entwicklungen, ist in Wirklichkeit ein großer Vorteil, der an die biologische Evolution erinnert: Veränderungen, die sich als nachteilhaft erweisen, sterben aus, während sich die beste Lösung langfristig durchsetzt. Dass ein solches System von seinen Partizipanten mehr kritisches Denken erfordert als eine Monokultur, ist klar.

Das Konzept der Distribution

Microsoft Windows und GNU/Linux unterscheiden sich auch fundamental in der Art und Weise, wie Software freigegeben wird. Mit dem Wachstum von GNU und Linux wurde es für Linux-Einsteiger immer schwerer, sich ihr System aus den vorhandenen Quellen selbst zusammen zu bauen. Zwar gibt es viele Bastler, die das nach wie vor tun, aber die große Mehrzahl der Nutzer bevorzugt es, eine Sammlung von Standardprogrammen mit Hilfe einer einfachen Installationsroutine auf den Rechner zu spielen. Mittlerweile gibt es so viele solcher so genannten Distributionen, dass das Satiremagazin BBSpot ironisch titelte: "Zahl der Linux-Distribution übertrifft Zahl der Nutzer".

Viele von diesen Hobby-Distributionen bestehen aus mittlerweile veralteten Programmen und krude zusammengebauten Installationsroutinen. Einige kommerzielle und ein paar nichtkommerzielle Distributionen dominieren derzeit das Feld, sie haben Namen wie Debian, Redhat, Mandrake und SuSE. Die in Deutschland mit Abstand beliebteste Distribution ist das in Nürnberg produzierte SuSE-Linux, das von 74% der ca. 10.000 Leser, die an der Heise-Online-Umfrage zu Linux teilnahmen, bevorzugt eingesetzt wird. In den USA dominiert die kommerzielle Redhat-Distribution das Feld, während eher technisch orientierte Nutzer die nichtkommerzielle Debian-Distribution einsetzen, die mit sehr vielen Raffinessen aufwartet, aber als etwas schwerer zu installieren und zu erlernen gilt. China hat sich dazu entschieden, eine eigene Distribution mit dem Namen Red Flag Linux zu entwickeln - doch die Hacker unter der roten Fahne werden von ihren Kollegen kritisiert, ihre Veränderungen am Quellcode nicht der restlichen Linux-Gemeinde zugänglich zu machen.

Viele Distributionen kann man von Linuxiso.org als CD-Images herunterladen. Mit einem CD-Brenner kann man sie dann völlig legal selbst herstellen. Was fehlt, sind die Handbücher und der Support. SuSE hat sich allerdings dazu entschieden, kein CD-Image seiner Distribution freizugeben, was sicherlich strategische Gründe hat, aber auch damit zusammenhängt, dass in der Distribution einige kommerzielle Demos enthalten sind, die nicht unbeschränkt weitergegeben werden dürfen.

Immerhin kann man sich von SuSEs FTP-Server die um die kommerzielle Software erleichterte Distribution aus dem Netz holen - Profis mit schneller Leitung können das Betriebssystem so komplett aus dem Internet installieren. SuSE weist andernorts auch explizit darauf hin, dass die Distribution frei kopiert und beliebig oft installiert werden darf. Auch die SuSE-eigenen Programme stehen im Quellcode bereit. So zeigt sich, dass viele Linux-Unternehmen eben auch eine andere Firmenphilosophie haben als im Software-Bereich üblich. Dass es auch anders geht, demonstriert Caldera mit seinem "OpenLinux": Für den kommerziellen Einsatz muss man hier eine Lizenzgebühr für jeden Nutzer im Unternehmen bezahlen

Das Konzept der Linux-Distribution unterscheidet sich fundamental von dem Distributionskonzept von Microsoft Windows. Während Microsoft selbst als Hersteller oder Lizenznehmer aller Programme auf einer Windows-Installations-CD fungiert, basteln Firmen wie SuSE und Redhat die Programme anderer zu einem runden Paket zusammen. Gleichzeitig unterstützen die Distributionshersteller Open-Source-Projekte, die nicht nur ihre eigene Distribution, sondern auch die der Konkurrenten wertvoller machen. Schließlich geht es allen darum, den Marktanteil von Linux zu erhöhen - außerdem ist der internationale Markt bereits recht gut aufgeteilt.

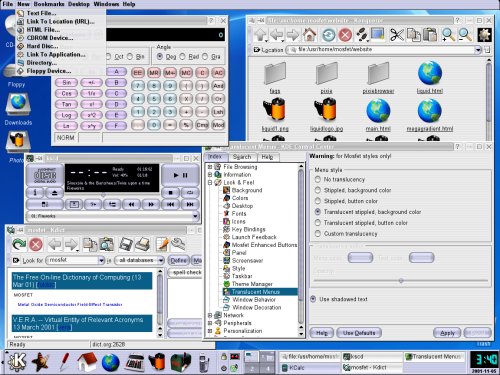

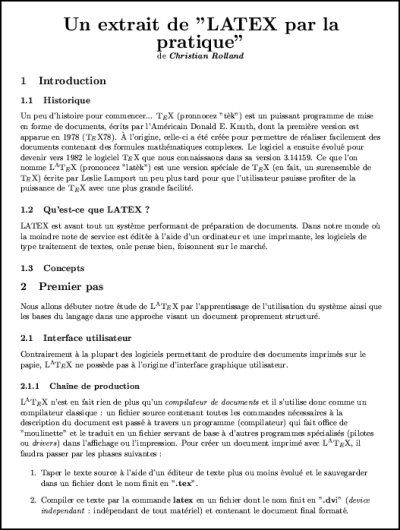

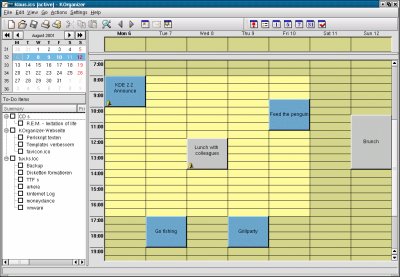

Während aktuelle Versionen des Microsoft-Betriebssystems nicht einmal einen brauchbaren Dekomprimierer für ZIP-Dateien enthalten, findet sich in einer Linux-Distribution fast alles, was die Linux-Welt an Software zu bieten hat. Wer z.B. SuSE-Linux kauft, findet auf den CDs Office-Software neben Programmiertools, Internet-Server neben Browsern, einen Napster-Client und Emulatoren für Spielekonsolen, etliche Texteditoren, ein Textsatzsystem, mehrere grafische Oberflächen, Instant-Messaging-Software usw. Da die Distributionshersteller meist nicht mit den Entwicklern direkt zusammenarbeiten oder gar identisch sind, werden oft Konkurrenzprodukte gemeinsam in der gleichen Distribution angeboten.

Wie groß ist GNU/Linux?

Die Natur des freien Betriebssystems macht es schwer, fundamentale Kenngrößen zu erfassen. Verkaufszahlen der einzelnen Distributionen sagen fast nichts über die eigentliche Verbreitung, da viele Nutzer nie eine Distribution kaufen oder mit einem Paket Dutzende oder gar Hunderte Rechner konfigurieren. Auch Umfragen sind problematisch, da Linux häufig an den Chefs vorbei (die oft der Microsoft-Rhetorik aufsitzen und Linux für eine Art Virus halten) in Unternehmen installiert wird. Webserver-Statistiken sind ebenfalls fragwürdig, da Linux-Browser sich oft als Windows-Browser ausgeben, um nicht auf Kompatibilitäts-Probleme zu stoßen. Sie bemessen außerdem nur den Einsatz von Linux auf dem Desktop, nicht auf dem Server.

Immerhin gibt es einen Linux-Counter, bei dem Linux-Nutzer sich registrieren lassen können. Etwa 190.000 User haben das bis Oktober 2001 getan - obwohl die Registrierung nicht Teil der Installation von Linux ist, außerdem die Eingabe einer gültigen Email-Adresse erfordert und nur per WWW möglich ist. Der Counter liefert auch wertvolle Statistiken z.B. über die geographische Verbreitung von Linux und erlaubt es, den Kontakt zu anderen Linuxern in der eigenen Region herzustellen.

1998 hat Red Hat, als Distributionshersteller nicht unbedingt unbefangen, in einem Paper die Zahl der Linux-Nutzer aufgrund verschiedener Daten weltweit auf 7,5 Millionen geschätzt. Mittlerweile liegen die Schätzungen teils deutlich höher, teils niedriger. Im Web hat Linux Windows bereits überholt. Google meldet im Oktober rund 37 Millionen Seiten mit dem Suchbegriff "Linux" und 33 Millionen mit dem Suchwort "Windows" (das deutlich weniger eindeutig ist). AltaVista bestätigt das Ergebnis mit rund halb so vielen Resultaten. Das zeigt zumindest, dass Linux-Nutzer an den Internetmedien einen überraschend hohen "Mindshare" halten, während Windows-Nutzer hier deutlich unterproportional ausfallen. Hier fällt sicher auch der starke Einsatz von Linux im akademischen Bereich und durch Power- wie Dauer-User ins Gewicht.

Größere Klarheit als bei der Frage der Verbreitung herrscht beim Umfang des Betriebssystems selbst. Einen guten Überblick liefert David Wheeler in dem Artikel Estimating GNU/Linux's Size: "Red Hat Linux 7.1 enthält über 30 Millionen Zeilen Quellcode. Mit Hilfe des COCOMO-Kostenmodells lässt sich eine Anforderung von 8.000 Mannjahren Entwicklungszeit errechnen." Würde man ein System dieser Größe kommerziell entwickeln, so Wheeler, müsste man dafür mindestens eine Milliarde Dollar ausgeben.

Linux Means Business

Eine Milliarde Dollar, das ist auch die Summe, die der größte IT-Konzern IBM in Linux investieren möchte. Seit der Ankündigung im Dezember 2000 hat sich tatsächlich einiges getan. Zu den Linux-Initiativen von IBM gehören:

Bereits vor der Milliarden-Ankündigung hat IBM mit der Portierung von Software und dem Aufbau von Linux-Clustern dem OS einigen Respekt verschafft. Natürlich handelt Big Blue nicht uneigennützig: Die Förderung von Linux anstelle hauseigener Lösungen ermöglicht es IBM, gleichzeitig Linux als Standard und sich selbst als das dazugehörige Unternehmen zu etablieren. Denn die Entwicklung von "Solutions", maßgeschneiderten Hard- und Software-Lösungen, ist IBMs Kerngeschäft, und neben Expertise zählt hier vor allem Marketing. Ganz nebenbei kann IBM auf diesem Wege Unternehmen wie Sun und Microsoft, die auf eigene, meist proprietäre Lösungen setzen, ins Abseits drängen.

"Peace, Love and Linux" verheißt IBM von Gebäudewänden und Bürgersteigen. |

Ob das gelingt, hängt vor allem davon ab, ob IBM es schafft, Manager von der Ernsthaftigkeit des Unterfangens zu überzeugen. Kampagnen wie "Peace, Love and Linux" zielen klar auf die Allgemeinheit, was darauf deutet, dass IBM Linux auch auf dem Desktop etablieren möchte. Unauffälliger wird IBM das Betriebssystem in seine eBusiness-Lösungen integrieren und so als unvermeidliche Standardplattform für den Server verbreiten. Klar ist: Linux hat sich eindeutig als sicheres Unix für unternehmenskritische Anwendungen bewährt - und das auch in Anwendungsbereichen, in denen Windows keine ernstzunehmende Alternative darstellt.

Riese in Bedrängnis

In vielen Bereichen, insbesondere in denen, die für das Internet relevant sind, liegen Microsofts Lösungen derzeit hinter der Konkurrenz zurück oder sind nicht profitabel. Microsofts Webserver IIS lag laut der regelmäßig aktualisierten Netcraft-Studie im September 2001 mit 28% Marktanteil deutlich hinter dem vor allem auf Unix-Systemen laufenden Open-Source-Webserver Apache, der mit 60% auf dem Löwenanteil der Systeme (mit eigener Domain) hält. Microsoft-spezifische Viren und Würmer wie Code Red und Nimda haben die Consulting-Gruppe Gartner veranlasst, ihre typischerweise sehr Microsoft-freundliche Haltung zu überdenken und in einem Bericht Unternehmen zum Wechsel auf Alternativen aufgefordert.

Im Datenbank-Bereich liegt Microsoft mit rund 15% Marktanteil wiederum hinter den Branchenriesen Oracle und IBM - kleine Websites setzen zudem oft auf kostenlose Open-Source-Lösungen wie MySQL und PostgreSQL. eCommerce-Gesamtlösungen sind die Spezialität von IBM, während die bedeutenden Internet-Redaktionssysteme ein Betätigungsfeld für viele Start-Ups sind. Auch hier existiert z.B. in Form des beliebten Zope-Applikationsservers eine mächtige Open-Source-Lösung.

Auch die Web-Entwicklungsumgebungen konnte Microsoft bisher nicht monopolisieren. Trotz Versuchen mit Skript-Standards wie ASP und VBS den Markt zu dominieren, entscheiden sich Entwickler lieber für offene Programmiersprachen, deren Werkzeuge sie kostenlos auf allen Plattformen einsetzen können und an deren Standards sie mitwirken können. Skript-Sprachen wie PHP, Perl und Python sowie die von Sun entwickelte plattformunabhängige, objektorientierte Sprache Java genießen eher das Vertrauen von Web-Entwicklern.

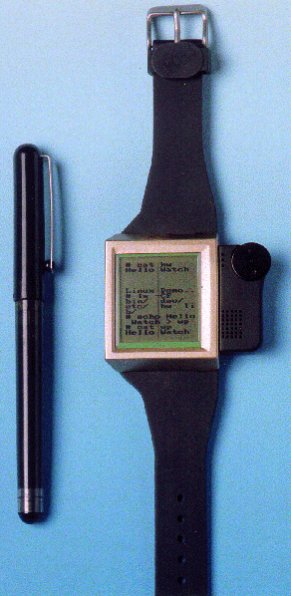

Und dann ist da noch der Markt für mobile Endgeräte und "Thin Clients" (Client-Rechner mit geringeren Anforderungen). Hier stehen Java, Palm OS & Co. gegen Microsofts Windows CE. Unter dem Namen Embedded Linux wird seit einiger Zeit auch eine Mini-Variante von Linux gestrickt, die auf das absolut Notwendige zurechtgestutzt ist. Mittlerweile gibt es Handies, Web-Telefone, PDAs, Spielekonsolen, Set-Top-Boxen, Web-Pads, Audio-Systeme, digitale Videorekorder und sogar Roboter, auf denen Linux läuft (eine gute Aufstellung findet sich bei Linux Devices).

Bei den Medienformaten hat Microsoft ebenfalls Nachholbedarf: Die Surfer bevorzugen derzeit Lösungen ohne Kopierschutz. DivX ;-) für Videos sowie MP3 und der patentfreie Audio-Codec Ogg Vorbis dominieren das Feld. Kopierschutz ließ sich bisher lediglich in Offline-Medien etablieren, etwa beim Vertrieb von DVDs oder in einigen Marktversuchen mit kopiergesperrten Audio-CDs. Microsofts eigenes Windows Media Format blieb bislang weitgehend glücklos, nur einige treue Microsoft-Fans setzen das proprietäre Format ein. Selbst als Player bevorzugen viele Nutzer den cooler aussehenden WinAmp von AOL.

"Hello watch": IBM hat es geschafft, Linux sogar auf einer Armbanduhr unterzubringen. |

Die Browser-Statistik von MetaGer sieht Microsofts IE zwar derzeit bei rund 80%, aber Netscape hält immer noch einen Anteil von rund 18% - mit dem bald erwarteten Final Release von Mozilla und dem kostenlosen Opera besteht außerdem für Microsoft die Gefahr, dass viele Microsoft-kritische Windows-Nutzer bei der erstbesten Gelegenheit umsteigen. All das macht es derzeit noch problematisch, den IE als Motor für proprietäre Standards zu nutzen.

Noch schlimmer für Microsoft sieht es bei den Instant Messengern aus. Instant Messenger führen eine Art Echtzeit-Adressbuch über die eigenen Freunde und Bekannten - man sieht, wann diese online sind und kann ihnen ggf. Nachrichten oder Dateien schicken. Hier dominieren die AOL-Messenger ICQ und AIM mit zusammen rund 150 Millionen Nutzern. Microsofts Messenger-Dienst verzeichnet dagegen nur 32 Millionen Nutzer, während mit rund 12 Millionen Nutzern Yahoo! auf Platz drei folgt. Die Open-Source-Gemeinde lässt sich nicht lumpen und schickt den offenen Jabber-Standard ins Rennen.

Und dann sind da noch die Inhaltsportale. Das Portfolio an Dienstleistungen, das Microsoft im Internet anbietet, ist bereits gigantisch. Wie auch Yahoo! und AOL betreibt Microsoft ein Portal, das Nachrichten, Suchmaschinen, diverse Inhalte, Email Funktionen, Messenger-Dienste, Verzeichnisse und vieles mehr vereint und mit Microsofts Desktop-Software wie dem MSN Messenger und dem Internet Explorer integriert ist. Doch obwohl in vielen Bereichen mehr Werbung als Inhalt zu finden ist, ist klar, dass dies nicht das Geschäftsmodell für Microsofts Internet-Service-Palette sein und bleiben kann.

Dank Sun, IBM, Linux & Co. ist die Vormacht von Microsofts Betriebssystem gefährdeter als je zuvor. Problematisch ist auch, dass Microsoft mit zunehmender Bandbreite für Heimbenutzer immer mehr von illegalen Kopien bedroht ist. CD-Brenner sind mittlerweile so schnell und günstig, dass auf jedem Schulhof Software im Nominalwert von Tausenden Euro getauscht wird. Wenn aber in wenigen Jahren jeder Nutzer durch den einfachen Login in eine P2P-Tauschbörse innerhalb von Sekunden ein Hunderte Megabytes großes Programmpaket auf seine Hunderte Gigabytes fassende Festplatte herunterladen kann, ist klar, dass das kommerzielle Verbreitungsmodell von Software in Gefahr ist. Microsoft realisiert solche Gefahren eher als z.B. die Musikindustrie - und weiß auch, welche Lösungen funktionieren und welche nicht.

Der Master-Plan von Microsoft zur Beseitigung der Konkurrenz heißt .NET - und er scheint aufzugehen.

Teil 2: Streit der Kulturen

Anfang 2000 übernahm Steve Ballmer die Führung von Microsoft. Ex-CEO Gates konzentriert sich seitdem auf die Leitung der Software-Entwicklung und die Verbreitung seines Reichtums. Dank einiger zirkulierender interner Videos hat Anfeuer-Experte Ballmer auch unfreiwillige Karriere als Musikstar gemacht. |

Microsoft bündelt wie Linux-Distributoren viele Programme mit dem Betriebssystem - Programme, die natürlich fast ausschließlich von Microsoft selbst stammen. So sorgte die Verbündelung von Windows 98 mit dem Microsoft Internet Explorer als Webbrowser für Aufsehen, gilt sie doch als ein Hauptgrund für den massiven Verlust von Marktanteilen des ehemaligen Browser-Königs Netscape. Doch das Bundling blieb ohne rechtliche Konsequenzen, und mittlerweile ist der IE fester Bestandteil aller Microsoft-Betriebssysteme. Wer ein Windows-System installiert und Microsofts Browser im Lieferumfang findet, wird sich kaum die Mühe machen, Netscapes Browser zu installieren, wenn er nicht weiß, worum es geht.

Und worum geht es? Microsoft hat als rein profitorientiertes Unternehmen natürlich kein Interesse daran, Programme zu verschenken (Netscape hatte dies ursprünglich auch nicht vor - man wollte den Browser eigentlich als kommerzielles Produkt verkaufen, sah sich jedoch durch Microsoft dazu gezwungen, das Programm kostenlos abzugeben). Die Microsoft-Strategie, den Browser-Markt zu dominieren, ist das Ergebnis kühler wirtschaftlicher Überlegungen: Sind erst mehr als 80% der Browser aus Redmond, kann Microsoft auf diesem Wege kommerziell relevante Standards etablieren. Neue Medienformate können in den Browser eingebunden werden und dafür Lizenzgebühren von Medienanbietern gefordert werden. Mit Inhalten wie ActiveX, die nur auf Microsoft-Systemen laufen, können Nutzer zunehmend dazu gebracht werden, ein Microsoft-OS zu installieren oder weiter einzusetzen. Und Microsoft-Dienstleistungen im Web können fest mit dem Betriebssystem verankert werden.

Nachdem der Software-Hersteller sein Ziel "Windows auf jedem Desktop" praktisch erreicht hat, tritt er auch in zahllosen anderen Bereichen als mächtiger Marktteilnehmer auf: Ob Handy oder PDA, Datenbank- oder Web-Server, Content-Management-System oder HTML-Editor, Spielekonsole oder eigenes Spieleangebot, ob Entwicklungsplattformen oder Enzyklopädie, Redmond ist überall. Nur im Internet ist es Microsoft bislang kaum gelungen, relevante Umsätze zu generieren.

Was ist .NET?

Im Juni 2000 stellte Microsoft, nun unter der Führerschaft von Steve Ballmer, seinen Master-Plan fürs Internet vor. Unter dem Namen .NET (sprich "dot-net") will Microsoft bisher von Konkurrenten dominierte Geschäftsfelder erobern und neue Bereiche erschließen. Da der Plan von so entscheidender Bedeutung für das Unternehmen ist, werden große Bereiche unter Verschluss gehalten, Pressemitteilungen nachträglich "korrigiert" und Artikel oder Leserbriefe lanciert, um die Entwicklung zu beschönigen. Was Microsoft plant, lässt sich am ehesten absehen, wenn man die Frage stellt: "Where is the money?" Denn im Gegensatz zu vielen New-Economy-Pleitiers ist Microsoft ein Unternehmen, das von allen Dingen vor allem eines versteht: die Maximierung des Profits. Und der lässt sich zum einen in den bereits erwähnten Bereichen machen, zum anderen in bisher unbesetzten oder unprofitablen Marktfeldern:

Doch bisher wird die totale Kontrolle durch die komplizierte Anmeldeprozedur erschwert. Regelmäßige Web-Surfer kennen das Problem der Verwaltung von Dutzenden Passwörtern. Über Cookies werden die entsprechenden Login-Bestätigungen auf dem Rechner des Nutzers gespeichert, was ein riesiges Sicherheitsproblem darstellt - insbesondere beim Surfen z.B. in Internet-Cafés, wo oft noch alte Login-Informationen gespeichert sind und man so fremde Daten lesen kann. Hinzu kommt, dass die eigentliche Identität der Nutzer aus Kostengründen so gut wie nie überprüft werden kann - meist genügt eine Email-Adresse zur Anmeldung.

Das Problem ist hier ähnlich wie beim E-Payment: Weil die Authentifizierungstechnik so essentiell ist, streiten viele Anbieter darum, die jeweils ihren eigenen Standard etablieren und so ein Monopol aufbauen möchten. Microsoft kann über das Betriebssystem den Nutzer sanft zur Anmeldung zwingen und so einen Großteil der Nutzer ins eigene Login-System integrieren. Web-Anbieter können für den Service zur Kasse gebeten werden: Wer die einfache Anmeldung auf seiner Site nutzen will, muss Microsoft dafür bezahlen.

Der Einstieg: Windows XP

Fast all das ist in der Tat Bestandteil des .NET-Konzepts und der damit verbundenen Lösungen. .NET spielt erstmals eine Rolle im neuen Microsoft-Betriebssystem Windows XP. Wie c't im Test der finalen Version von Windows XP berichtet [4], sind Kernelemente der neuen Strategie fest mit dem Betriebssystem verknüpft. Die mit dem Internet Explorer erfolgreich erprobte Verbündelung von Software- und Service-Komponenten wird in XP konsequent fortgesetzt.

Den Authentifizierungsdienst und damit die Grundlage für spätere Entwicklungen wie E-Payment und Abonnement-Channels für Inhalte bietet Microsoft derzeit unter dem Namen Passport an. "Ein einfacher Weg zur Anmeldung und zum Einkaufen", verspricht Microsoft und konkurriert damit mit Yahoo! ("IDs") und AOL ("ScreenName"), die über ihre Portale die gleiche Leistung anbieten möchten. Passport verwendet konventionelle Cookies und JavaScript (nicht zu verwechseln mit Java), um die Login-Informationen auf dem Rechner des Nutzers zu speichern. Wer einen Hotmail-Account nutzt oder elektronische Bücher mit dem Microsoft Reader lesen möchte, muss bereits seit längerer Zeit einen Passport-Zugang einrichten.

In Windows XP wird der Nutzer bei der ersten Internet-Verbindung ermahnt: "Sie brauchen ein Passport-Konto, um Windows XP Internet-Kommunikationsfunktionen zu nutzen und auf .NET-basierte Internetdienste zugreifen zu können." Hier wird der Sinn der Microsoft-Terminologie klar: Im Englischen kürzt man Internet oft schlicht mit "Net" ab, und auch der Rest der Formulierung legt dem Nutzer nahe, Internet ginge ohne Passport gar nicht. Wer im Mehrbenutzer-System XP neue Nutzer einrichtet, soll diesen ebenfalls einen Passport verschaffen: virales Marketing.

Microsofts Flagge auf der Seattle Space Needle. Mit Windows XP will der Konzern den endgültigen Siegeszug antreten. |

Während die Sicherheit von Passport vernichtend kritisiert wurde [5], überraschte Microsoft mit der Ankündigung, Passport nicht als Monopolist handhaben zu wollen, sondern mit anderen "Universal Sign In" Anbietern (also AOL und Yahoo!) zusammen zu arbeiten. Die verschiedenen "Identities" würden schlicht auf unterschiedlichen Servern verwaltet, aber einen gemeinsamen Standard nutzen. Dahinter können verschiedene Überlegungen stecken. Zum einen besteht die Möglichkeit, Interoperabilität nur vorzutäuschen und in der Praxis über Implementierungsdetails, insbesondere bei der Vergabe von Rechten auf einer Website, Mitbewerber auszuspielen - dies befürchtet Andrew Orlowski vom industriekrisischen The Register und verweist darauf, dass Microsoft vor einiger Zeit das Internet-Magazin Slashdot mit rechtlichen Schritten bedroht hat, weil dort die technischen Spezifikationen der Microsoft-Implementierung des Authentifizierungsprotokolls Kerberos veröffentlicht worden.

Solche Maßnahmen sind eher untypisch für Microsoft: Man bemüht sich sehr, das Unternehmen als wettbewerbsfreundlich, kritikfähig und offen darzustellen, um dem Bild vom bösartigen Großunternehmen, das wie ein Krebsgeschwür langsam alle Industriebereiche verschlingt und so die gesamte Volkswirtschaft Zelle für Zelle zerstört, vorzubeugen. Wenn Microsoft rechtliche Schritte androht, geht es also ums Ganze. Daraus kann man ziemlich sicher schließen, dass Microsoft nach außen hin Offenheit vortäuschen möchte, über die eigene Implementierung aber die Konkurrenz sabotieren will. Denkbar ist aber auch, dass man dank der Verknüpfung von Passport mit Windows schlicht keine Angst vor Mitbewerbern hat - wenn jeder Windows-Nutzer ohnehin Microsofts Dienst in Anspruch nimmt, kann der Rest getrost bei anderen Anbietern unterkommen, was gleichzeitig ein gutes Argument in Anti-Trust-Verhandlungen ist.

Der Microsoft Messenger, der (wenig überraschend) mit Windows XP verbündelt ist, fordert vor der Nutzung ebenfalls zur Einrichtung eines Passport-Zugangs auf. Das ist deshalb bedeutsam, weil mit dem Messenger eine Microsoft-eigene Remote-Access-Lösung verknüpft ist. Damit lässt sich ein anderer Rechner fernwarten, was vor allem auch PC-Anbieter nutzen sollen, um per Internet Support zu leisten.

Programme zu vermieten

Ob das jedoch die primäre Intention von Microsoft ist, darf bezweifelt werden -- schließlich hat man vor Windows 2000 die wichtigen grafischen Fernwartungsfunktionen nicht ins System integriert und es Fremdanbietern überlassen, hier Lösungen zu entwickeln. Das plötzliche Interesse von Microsoft ist vermutlich eher mit dem Wunsch erklärbar, den Nutzer über den Messenger und andere Anwendungen mittelfristig mit Applikationsservern vertraut zu machen.

Denn die Fernwartungstechnik benötigt man auch zur Vermietung von Software. Damit lässt sich langfristig das Software-Angebot von Microsoft immer mehr ins Internet verlagern. Von Microsofts Servern (oder denen anderer Anbieter) kommen nur hochkomprimierte Bild- und Tondaten, die mit Programmen erzeugten Daten werden entweder auf dem eigenen Rechner oder auf dem Server gespeichert. Für eine monatliche "Flatrate" oder zeitgebundene Gebühren erhält der Nutzer dann das Recht, ein bestimmtes Programm zu benutzen.

Um die Nutzer an die Technik zu gewöhnen, könnte Microsoft z.B. jedem Passport-Neukunden eine kostenlose "Probezeit" von Tagen oder Wochen einräumen, innerhalb derer Software wie Word, Excel und Outlook, aber auch z.B. die Enzyklopädie Encarta oder Microsofts HTML-Editor Frontpage kostenlos genutzt werden kann. Flaschenhals ist allein die Bandbreite, ist diese ausreichend vorhanden, lassen sich auch Spiele oder Virtual Reality übers Netz streamen. Bestimmte Anwendungen könnten sogar komplett kostenlos angeboten werden, sofern der Nutzer einwilligt, alle Daten für Profilzwecke Microsoft zu überlassen.

Wenn bestimmte Programme irgendwann nur noch "mietbar" sind, besteht zwar die Gefahr, Kunden zu verlieren, doch die langfristige Sicherheit eines Abonnenten könnte Microsoft dieses Risiko akzeptieren lassen. Letztlich wäre ein solches Szenario die Rückkehr ins Terminal-Zeitalter, als Firmenangestellte mit "dummen" Endgeräten auf große Rechneranlagen zugriffen, wo alle Daten und Programme gespeichert waren, damals noch meist durch den ehemaligen Oberbösewicht IBM. Die Konsequenzen sind leicht ausmalbar: mangelnder Datenschutz, Geschwindigkeits- und Verfügbarkeitsprobleme, höhere Kosten für den Endnutzer, stärkere Monopolisierung über Dauerverträge und langfristige Förderung einer Software-Monokultur, Einschränkung der Möglichkeiten der persönlichen Datenverwaltung, mögliche Gefährdung der Meinungsfreiheit [6], Sicherheitsmängel usw. usf.

Für eine solche Strategie spricht auch Microsofts umstrittene "Aktivierung" von Windows XP: Bestätigt man nicht, dass man der legitime Käufer ist, darf man das OS nicht nutzen. Hier wird erstmals das Betriebssystem unvermeidlich mit einer externen Stelle (man hat noch die Wahl zwischen Telefon- und Internet-Aktivierung) verknüpft. Doch während dieser Schutz sich von Crackern noch ohne Probleme aus dem Betriebssystem entfernen ließ, kann stufenweise der "Schutz" des Systems erhöht werden, indem mehr und mehr Software auf Microsofts Server verlagert wird.

Microsofts Inhalte

Am Rande ist erwähnenswert, dass Microsoft natürlich auch seine eigenen Inhalte immer stärker ins Betriebssystem und in die Anwendungen integriert. So verfügt das neue Office XP über sogenannte "Smart Tags", die z.B. bei der Eingabe eines Aktiensymbols dieses hervorheben und auf einen Mausklick hin weitere Informationen aus dem Internet holen. Das Feature war ursprünglich auch für den neuen Internet Explorer 6 vorgesehen und sollte dort Links in fremde Seiten einfügen, hat aber für viel Kritik gesorgt - Web-Autoren sehen ihre Werke der mutwilligen Verfälschung durch Microsoft ausgesetzt. Microsoft hat sich deshalb entschieden, die Smart Tags vorläufig aus dem Browser zu entfernen.

Langfristig möchte man auch andere Service-Anbieter in die Microsoft-Strategie einbinden. Deshalb fördert Microsoft offene Standards wie SOAP und UDDI, die die Kommunikation unter verschiedenen Endgeräten erleichtern und die Abfrage von Services nicht nur aus dem Browser, sondern aus beliebigen Programmen erlauben. Dahinter steckt die Überlegung, dass man sowohl bei den Endgeräten als auch bei den Services selbst auf absehbare Zeit kein Monopol haben wird -- um die Akzeptanz und Verbreitung der eigenen Services sicher zu stellen, müssen diese deshalb interoperabel sein. Das wird Microsoft natürlich nicht daran hindern, auch in diesen Bereichen langfristig eine Markführerschaft anzustreben und über Implementierungsdetails wie bei Passport Interoperabilität zu verhindern, sobald in einem Bereich ein Monopolstatus erreicht ist.

Write Once, Run on Microsoft

Auf mobilen Endgeräten und auf Servern muss Microsoft langfristig der Sun-Programmiersprache Java dem Garaus machen. Java hat den Vorteil, tatsächlich auf jeder Plattform zu laufen -- wenn auch in vielen Bereichen mit starken Performance-Einbußen. "Write Once, Run Anywhere" (WORA) - mit diesem Lockruf hat Sun Tausende von Entwicklern mobilisiert.

Erreicht wird die Plattformunabhängigkeit durch eine sogenannte "Virtuelle Maschine", eine Art simulierter Rechner im Rechner, der auf jedem Java-System identisch ist. Gegenüber der als kompliziert, unsicher und umständlich geltenden Programmiersprache C++ genießt Java den Ruf, vergleichsweise leicht erlernbar, schneller programmierbar und absturzsicher zu sein. Kritiker weisen auf die deutlich schlechtere Performance in allen Bereichen hin, die man z.B. im Great Computer Language Shootout nachprüfen kann: Java schneidet sogar oft schlechter ab als Skriptsprachen wie Perl und Python, die noch einfacher zu erlernen und genauso plattformunabhängig sind.

Vor allem im Servereinsatz ist Java aber weiterhin beliebt, und der GNU Java Compiler (gcj) verspricht höhere Performance durch Verzicht auf die virtuelle Maschine. Der Quellcode bleibt trotzdem plattformunabhängig, muss aber in diesem Fall für jede Plattform neu kompiliert werden.

Java war aus Microsofts Sicht schon immer eine massive Bedrohung. Denn während ein Windows-Programm nur mit viel Mühe auf ein anderes Betriebssystem portierbar ist, ist plattformunabhängige Programmierung praktisch das Ende des Betriebssystem-Monopols. Und weil Java im Gegensatz zu den meisten Skript-Sprachen auch mehrere grafische Oberflächen mitbringt, lassen sich darin beliebige Desktop-Anwendungen entwickeln.

Von Microsofts Seite hat man versucht, dies zum Teil durch "Verunreinigung" des Java-Standards mit Microsoft-spezifischen Erweiterungen zu verhindern: Die gleiche Strategie, die auch in vielen anderen Bereichen, in denen Microsofts Plattformmonopol in Gefahr ist, angewendet wird oder werden könnte. Sun hat daraufhin im Januar 2001 Microsoft die Lizenz entzogen, neue Java-Entwicklungssoftware zu produzieren.

Damit war die "Verunreinigungs"-Strategie nicht mehr gangbar, was sich schon seit längerer Zeit abgezeichnet hat. Microsoft hat deshalb die wenig überraschende Konsequenz gezogen und die Java-Unterstützung aus der neuesten Version des Internet Explorer entfernt: Wenn Java schon auf Windows läuft, dann nicht mit Microsofts Hilfe. Suns Java-Strategie ist durchaus umstritten. Mittlerweile muss man rund 5,5 MB downloaden, nur um Java-Programme überhaupt ausführen zu können, und Programme mit grafischer Oberfläche sind unter Windows erschreckend langsam und speicherintensiv. Entwickler und Universitäten nahmen die Programmiersprache dennoch mit Begeisterung an, in der Hoffnung, ohne Microsoft auch für Windows-Systeme entwickeln zu können -- und zwar kostenlos. Akademiker loben die Sprache wegen ihrer technischen Überlegenheit, während viele Endnutzer die Nase rümpfen, wenn sie das Wort Java hören.

Microsoft hat also gute Chancen, Java zu begegnen. Dies tut man innerhalb des .NET-Konzepts mit der sogenannten Common Language Runtime. Die CLR funktioniert ähnlich wie der Bytecode von Sun: Beliebige Sprachen lassen sich in diese Zwischensprache übersetzen. Doch im Gegensatz zu Suns Bytecode lässt sich der CLR-Code natürlich, wie beabsichtigt, nur auf Microsoft-Systemen ausführen. Das bietet Entwicklern immerhin den Vorteil, z.B. mobile Endgeräte gleichzeitig mit Desktop-PCs zu bedienen, außerdem kann Microsoft die CLR ja durchaus für ausgewählte Betriebssysteme wie MacOS lizenzieren (Microsoft und Apple kooperieren im Software-Bereich).

Um den Java-Ersatz zu vervollständigen, setzt Microsoft noch eine eigene Programmiersprache, C# (sprich "C-Sharp"), obendrauf und aktualisiert Visual Basic für die .NET-Unterstützung. Damit sollen Javas sprachliche Vorteile assimiliert werden, während man gleichzeitig Java performance-mäßig ausbooten kann: Da die CLR für Windows-Systeme optimiert ist, kann sie weitaus schneller laufen als Java, das z.B. eine ganz eigene grafische Benutzeroberfläche verwendet.

Rettung durch Mono?

Wieder einmal scheint es die Open-Source-Gemeinde zu sein, die Microsofts ratloser kommerzieller Konkurrenz aus der Patsche helfen muss. Zum Entsetzen mancher Microsoft-Gegner hat Ximian, die Mutterfirma des GNOME-Desktops, angekündigt, Teile des .NET-Konzepts als Open-Source-Projekt vor allem für Linux zu implementieren. Dabei soll es nicht um Passport, "Smart Tags" oder ähnliche fragwürdige "Innovationen" gehen, sondern um die Entwicklung eines Compilers für C# und eine Implementierung der Common Language Runtime sowie bestimmter notwendiger Bibliotheken (Grafik, Web-Zugang usw.).

Dabei kann sich das Team rund um den gebürtigen Mexikaner Miguel de Icaza beim Projekt mit dem Namen Mono auf die von Microsoft veröffentlichten Spezifikationen stützen. Microsofts Vorzeige-Entwickler David Stutz, der oft eine kritische Haltung zu Microsofts Unternehmenspolitik einnimmt, begrüßt in einem Interview den Vorstoß von Ximian: "Wir brauchen Interoperabilität, weil unsere Kunden sie brauchen, und weil unsere Kunden sie brauchen, brauchen wir sie."

Ximian traut dem Frieden weniger. "Wir versuchen, was Patente angeht, auf der sicheren Seite zu bleiben", sagt Icaza im Slashdot-Interview. "Das bedeutet, dass wir Mono mit Techniken implementieren, die in der Vergangenheit erfolgreich verwendet wurden, und dass wir derzeit noch nicht sehr effizienten oder überlegten Code entwickeln. Davon sind wir noch weit entfernt. Aber dafür setzen wir nur existierende Techniken ein." Das Patent-Problem schwebt also wie ein Damoklesschwert über dem Open-Source-Projekt.

Diese Befürchtung teilt auch das DotGNU-Projekt, das eine komplett eigene Alternative zu .NET entwickeln will, inklusive einer dezentralen Authentifizierung als Antithese zu Microsoft Passport. Hier will man durch möglichst viel dokumentierte Eigenentwicklung der Patentierbarkeit der verwendeten Konzepte vorbeugen. Sicherlich besteht auch die Gefahr, dass Microsoft zwar Entwicklungen wie Mono nicht auf rechtlichem Wege begegnet, aber den Standard so häufig verändert, ohne dies zu dokumentieren, dass Mono nicht mehr mithalten kann. Diese Gefahr besteht bei DotGNU nicht, und die unterschiedlichen Strategien haben bereits zum Streit zwischen den beiden Projekten geführt -- was vielleicht besser ist, als es klingt, denn so können beide Ansätze parallel erprobt werden.

Patentierte Programme

Die internationale Patentierbarkeit von Software ist ein wesentliches Hindernis für die Entwicklung freier Software. Patente können auch gegen nichtkommerzielle Projekte eingesetzt werden, sofern die entsprechenden "Erzeugnisse" öffentlich angeboten werden (vgl. z.B. §11 PatG). In seinem Artikel Wettbewerb im Gerichtssaal (c't 17/2001) beschreibt Richard Sietmann detailliert, wie die Erfindungshöhe, vorgeblich Maßstab für die Patentierbarkeit einer Erfindung, mit zunehmender technischer Komplexität an Bedeutung verliert. Die Patentprüfer sind nicht in der Lage, eingereichte Patente zu bewerten, so dass die einzige verbleibende Prüfungsinstanz die Gerichte sind. Dort kommt es dann nur noch auf die technischen Experten an, die nicht unbedingt kompetent sein müssen, sondern vor allem überzeugend. Gleichzeitig wird seitens der Großunternehmen, Patentanwälte und Venture-Capital-Gesellschaften massiv Lobbyismus für immer stärkeren Patentschutz betrieben - eine Spirale, die kein Ende zu nehmen scheint und nun auch auf genetische Informationen eskaliert.

Das gilt auch für Patente auf Verfahren, die lediglich in Software-Form, also in Form von Information, implementiert werden - ein zusätzliches Monopolrecht für Erfinder neben dem schon international geltenden Copyright und dem Markenrecht. Das "Free Patents" Projekt dokumentiert in zahlreichen Beispielen die Grenzenlosigkeit des Patentwahns in den USA und zunehmend auch in Europa - einige der skandalösesten Fälle findet man auch in Slashdots Patentrubrik. Vom Online-Einkaufswagen bis zur Web-Datenbank, von der Online-Auktion bis zum Hyperlink - ob eine Technologie schon tausendfach implementiert wurde oder selbst von einem Schimpansen mit genügend großem Futteranreiz problemlos entwickelt werden könnte, scheint sowohl bei Software-Patenten als auch bei traditionellen wie dem berühmt gewordenen Erdnussbutterbrot-Patent selten eine Rolle zu spielen. Bei der Patentschrift wird mehr Wert auf die Form und die Eloquenz als auf den Inhalt gelegt.

Das erinnert an die Situation im England des 17. Jahrhunderts, als eines der ersten Patente, das vor Gericht angefochten wurde, das Spielen mit Karten betraf. [7] Der Unterschied heute: Mit genügend großen finanziellen Mitteln lässt sich selbst das unsinnigste Patent oft bis zu seinem Verfall (der bei Software genauso lange dauert wie z.B. bei einer patentierten Bohrmaschine) aufrecht erhalten.

Nicht nur Software steht zunehmend unter Monopolschutz: Greenpeace-Aktion vor dem Europäischen Patentamt in München gegen Patente auf Leben. Foto: Christian Lesten. |

Patente fördern praktisch nur die Unternehmen, die es sich leisten können, sie zu verteidigen -- und zementieren so Monopole. Sie machen Open-Source-Entwicklung in vielen Bereichen schlicht völlig unmöglich, da man ein Programm, das ein Patent verletzt, eben nicht freigeben darf. Das weiß natürlich auch Microsoft, so dass es im Halloween-Dokument 1 unter anderem hieß: "Der Effekt von Patenten und Copyrights bei der Bekämpfung von Linux muss untersucht werden." Der Widerstand gegen Patente kommt wie auch bei .NET fast ausschließlich aus der Open-Source-Community und von einigen wenigen kleinen und mittelständischen Unternehmen, die langfristig denken.

Die "KMUs" gehen dem Gerede von "Intellectual Property Rights" nur zu häufig auf den Leim. Aus der Sicht der Großunternehmen ist es von Vorteil, dass die Mehrzahl der aufstrebenden Konkurrenz Closed-Source-Software einsetzt und so isolierte Lösungen nutzt, anstatt die gemeinsame Intelligenz über Open-Source-Software und Patent-Pools zu bündeln und damit gestärkt größeren Unternehmen entgegenzutreten. Das stünde nicht im Widerspruch zu einer gesunden Konkurrenzsituation, aber sehr wohl zu dem Gedanken, jedes Unternehmen müsse ein absolutes Monopol anstreben. Es werden also vor allem Unternehmen mit modernen Philosophien sein, die Open-Source-Software einsetzen und damit der Konkurrenz ein Schnippchen schlagen.

Mehrheit in Euros

In einem Auftragsbericht analysierte die Europäische Union die öffentliche Reaktion auf die geplante Gesetzgebung zu Software-Patenten. Zwar seien 91% der Befragten gegen Software-Patente gewesen, stellte der Report fest, aber diese stammten fast ausschließlich aus der Linux-Gemeinde. Dagegen gebe es eine "wirtschaftliche Mehrheit" für Software-Patente. In der Beschreibung der Reaktionen ist auch die Wortwahl interessant: Wer eine breitere Patentierbarkeit von Software fordert (also größere Monopolrechte), ist demnach "liberal", diejenigen, die keine Software-Patente wollen, sind "restriktiv".

Ein Grund für den geringen öffentlichen Widerstand gegen Patente ist sicherlich, dass das gesamte Patentproblem aus der Sicht eines Windows-Benutzers keine große Rolle spielt: Er kann sicher sein, dass Microsoft stets alle Schlüsseltechnologien lizenzieren oder sich aufrichtig um ihre Vernichtung bemühen wird. Gleichzeitig wird in den nationalen Medien über Entwicklungen auf europäischer Ebene ohnehin kaum berichtet - viele EU-Kritiker sehen die Entfernung der Demokratie von den Bürgern als ein Hauptproblem des Vereinigungsprozesses. Internationale Schattenorganisationen wie WIPO und WTO tun ihr Übriges, um eine Teilnahme der Öffentlichkeit am entscheidungsrelevanten Diskurs zu verhindern.

In den USA ist der Patentkrieg längst verloren, in Europa wird er noch gefochten, doch die Zeichen stehen auf Sturm. Dabei gäbe es juristisch eine einfache Lösung für die Problematik, mit der auch Patentfreunde leben können sollten: Software mit offenen Quellcode prinzipiell von allen Lizenzgebühren freizustellen. Denn wer argumentiert, dass Software-Patente notwendiger Innovationsschutz seien, wird einsehen müssen, dass dieser Schutz überflüssig ist, wenn die Innovation in gleicher Qualität auch von der Free-Software-Kultur bereitgestellt wird. Eine Analogie aus der realen Welt wäre es, Patentverletzungen dann zu erlauben, wenn der patentierte Gegenstand nicht verkauft, sondern verschenkt wird, mitsamt allen Konstruktionsunterlagen. Doch dafür würden sich europäische Politiker wohl nur auf Druck ihrer jeweiligen Landesmedien einsetzen -- Medien, die oft nur eine diffuse Vorstellung davon haben, was ein Betriebssystem eigentlich ist.

Vielleicht gibt es die Möglichkeit, das Prinzip der GPL auf Patente zu übertragen - z.B., indem Open-Source-Entwickler selbst möglichst viele Patente anmelden und diese in einen gemeinsamen Pool übertragen, der auch die Patentkosten tragen würde. Nur wer selbst freie Software entwickelt oder eigene Patente dem Pool beisteuert, dürfte die enthaltenen Patente kostenfrei nutzen. So könnte das Patentsystem langsam von innen zersetzt werden, da der gemeinsame Pool von Open-Source-Entwicklern und kleineren Unternehmen mit der Zeit auch für Großunternehmen gefährlich werden könnte, die dann keine andere Wahl mehr hätten, als selbst ihre Patente beizusteuern. Ein Ansatz in diese Richtung ist z.B. das Open-Patents-Projekt. Ob eine Idee von dieser Radikalität, die unter underem voraussetzen würde, auch fragwürdige Patente anzumelden, von der Linux-Community akzeptiert würde, darf allerdings bezweifelt werden.

Geschützte Bits

Ein weiteres Problem für Open-Source-Entwickler ist der Verfall des Copyright-Systems. Was viele Downloader freut, wird von der "Content-Industrie" derzeit mit Panikreaktionen beantwortet. Jedes Bit, das beim Kunden landet, ob zu einem Musikstück, einem eBook oder einem Film gehörend, soll "unkopierbar" gemacht werden. Dafür bieten sich verschiedene Techniken an, vor allem die temporäre Verschlüsselung der Inhalte, die erst mit einem z.B. in der Wiedergabesoftware enthaltenen Key aufgehoben werden kann, sowie die Versehung der Daten mit einem "Wasserzeichen", was sich bei Kopiervorgängen von der Hardware und Software erkennen lässt, woraufhin das Kopieren unterbunden werden soll.

Dass keines dieser Systeme sicher ist, wird von nahezu allen Experten, auch industrieeigenen, akzeptiert. In seinem berühmt gewordenen Paper zum Wasserzeichen-Verfahren SDMI resümiert Professor Edward Felten: "Letztendlich wird ein Konsument, der in der Lage ist, geschützte Inhalte zu hören oder zu sehen, technisch auch immer in der Lage sein, sie zu kopieren."

Das weiß auch die Content-Industrie, die Felten und andere in einem Wettbewerb zum Cracken von SDMI aufgefordert hatte - und anschließend bei der Veröffentlichung der Ergebnisse mit rechtlichen Schritten bedrohte. Kopierschutz beruht nicht auf technischen Verfahren, sondern auf Gesetzen, die es verbieten, ihn zu umgehen. In den USA existiert das wesentliche Gesetz hierzu bereits in Form des DMCA, in Europa muss die entsprechende EU-Richtlinie nur noch von den Mitgliedsstaaten umgesetzt werden. So kann jeder, der einen Kopierschutz umgeht, verklagt und eventuell sogar eingesperrt werden, selbst wenn das der Wiederherstellung ansonsten eingeschränkter Rechte (z.B. dem Kopieren von Text in die Zwischenablage) dient. Typisch dafür ist der Fall des in den USA festgenommenen russischen Programmierers Dmitry Sklyarov, der Adobes teils lächerlichen eBook-Kopierschutz geknackt hatte.

"Lesen ist ein Recht, kein Feature": Proteste in San Jose für die Freilassung des russischen Programmiers Dmitry Sklyarov |

Auch Wissenschaftler bewerten mittlerweile den DMCA als eine Gefahr für die freie Meinungsäußerung. In einem Artikel für die Zeitschrift Science gebraucht Professor Pamela Samuelson von der Universität Kalifornien ungewöhnlich deutliche Worte: "Die wissenschaftliche Gemeinde muss die Auswirkungen dieser neuen Regeln erkennen", warnt Samuelson. "Nur zu oft haben in der Vergangenheit die Gerichte in Konflikten zwischen geistigem Eigentum und dem Recht auf freie Meinungsäußerung das Eigentum als höher bewertet." Weitaus weitergehend als der bereits heftig kritisierte amerikanische DMCA (der ein Ergebnis internationaler WIPO-Veträge ist, siehe Understanding WIPO) ist ein derzeit vorliegender Gesetzentwurf, der sogenannte SSSCA, der es gar verbieten würde, Geräte zu verkaufen, die keine Kopierschutz-Funktionen enthalten: Der Traum der Content-Industrie.

In seinem Artikel Was ist falsch am Kopierschutz? erklärt John Gilmore von der EFF im Detail die mit Kopierschutz verbundenen Probleme, insbesondere für die Open-Source-Community. Kopierschutz und die Ideale freier Software widersprechen sich fundamental. Der einzige Grund, warum z.B. DVDs derzeit unter Linux nicht vernünftig abspielbar sind, ist der Kopierschutz CSS. Abspielen unter Umgehung des Kopierschutzes zu ermöglichen ist in den USA illegal und wird von der Filmindustrie teils massiv verfolgt. Kopierschutz in offenem Quellcode zu implementieren ist offensichtlich ein hoffnungsloses Unterfangen, da er ja jederzeit entfernt werden kann. Kostenlose Programme in binärer Form nur für diese Aufgabe dem Betriebssystem beizufügen, würde viele Open-Source-Freunde ärgern, aber auch nicht funktionieren, da für die verschiedenen DVD-Standards Lizenzgebühren zu entrichten sind. Und so wie es bei DVDs geht, geht es auch bei eBooks, neuen "sicheren" Musikformaten usw.

Die Konsumenten, die mit ihrem Player DVDs ohne Nachdenken abspielen können, sind sich der Problematik natürlich meist nicht bewusst. Und das, obwohl z.B. durch DVDs ihre Rechte bereits stark eingeschränkt werden: Schnelles Vorspulen ist während der Werbeblöcke in DVDs nicht mehr möglich, und man kann nur DVDs aus einer Verkaufsregion auf dem Player abspielen. Aus den USA importierte DVDs funktionieren also nicht in deutschen Playern. Der Hintergrund: In Europa sind DVDs oft etwa doppelt so teuer wie in den USA. Deshalb geht jetzt auch die EU-Kartellbehörde gegen die Filmindustrie vor.

Wer Windows benutzt, wo die entsprechenden Kontrollschemata immer weitgehend problemlos funktionieren werden, stimmt damit der Einschränkung seiner Rechte zu - selbst wenn das Betriebssystem raubkopiert ist. Je mehr Nutzer dagegen Linux & Co. verwenden, desto schwieriger wird es, Kopierschutz in Massenprodukte zu integrieren, ohne auf breiten Widerstand zu stoßen.

Was hätte George Orwell zum DMCA gesagt? "Kein Tier soll die Redefreiheit eines anderen einschränken - ohne Grund". Mit freundlicher Genehmigung von Keith Handy. |

Open-Source-Freunde sind oft der Meinung, dass die Mainstream-Kultur bald durch ein freies, offenes Äquivalent ersetzt werden kann und die Content-Industrie damit überflüssig wird. Das Problem mit dieser Sichtweise sind die durch Lobbyismus erreichten Gesetze wie der DMCA, die nicht so schnell verschwinden und die freie Entwicklung und freie Rede massiv bedrohen. Weiterhin wird eine langfristige Nichtverfügbarkeit von Mainstream-Medienformaten in Linux-Distributionen die Entwicklung dieser "freien Kultur" gefährden. Denn wenn eine friedliche Koexistenz nicht möglich ist, ist das so, als würde man vor der Anmeldung eines Internet-Zugangs seinen Fernseher abschaffen müssen.

Propaganda und Ideologien

Dass sich Vertreter von Open Source und Closed Source zunehmend als Parteien in einer Art Software-Krieg begreifen, wird auch deutlich durch die etwas unbeholfene, aber recht praktische Software War Map, eine Art Strategiekarte der derzeitigen Konflikte. An allen Fronten wird gegen "Imperator Bill" gekämpft. Dabei geht es nicht nur um die Entwicklung von Software, sondern auch um Propaganda von beiden Seiten.

Die Propaganda von Microsoft gegen die GPL wurde bereits erwähnt. Im Rahmen des Antitrust-Verfahrens gegen Microsoft wurden noch andere Mittel eingesetzt. Ein Artikel in der LA Times von 1998 beschreibt einen Plan Microsofts zur Image-Aufbesserung:

Den Dokumenten zufolge sollen lokale PR-Agenturen ab nächster Woche Kommentare bei den Medien einreichen, weitere Veröffentlichungen sollen in den nächsten Monaten folgen, dazu gehören glühend verehrende Aussagen von Microsoft-Partnern, Konsumentenumfragen und Studien, die den Einfluss der Firma auf die Wirtschaft jeder Region zeigen sollen.Leserbriefe sollen von erfolgreichen Unternehmern der jeweiligen Region erbeten werden. Kommentare sollen von freien Journalisten und eventuell einem "Volksökonom" geschrieben werden, so ein Dokument. Die Autoren sollen bezahlt werden, indem sie ihre Kosten "Microsoft als Auslagen in Rechnung stellen".

Durch solche Kampagnen wird eine breite Unterstützung von Wirtschaft und Verbrauchern vorgetäuscht, ergänzt durch die üblichen Anzeigenkampagnen und Sponsorveranstaltungen von Microsoft, in denen auf die "Freiheit der Innovation" hingewiesen wird. Während das Graswurzel-Projekt von Microsoft einen kleinen Proteststurm auslöste, merken die Autoren John Stauber und Sheldon Rampton in ihrem neuen Standardwerk über die PR-Industrie, "Trust Us, We're Experts!" [8], an:

Ein Jahr später blieb es [in der Computerpresse] unerwähnt, als mehrere Artikel einen "Offenen Brief an Präsident Clinton von 240 Wirtschaftsexperten" diskutierten, der in Form von ganzseitigen Anzeigen in der Wahshington Post und der New York Times erschien. Die Anzeigen wurden bezahlt durch einen nichtgewerblichen "Think Tank" namens "Independent Institute" mit Sitz in Kalifornien.

Der Brief der Experten kritisierte das Kartellverfahren gegen Microsoft, da es die US-Wirtschaft gefährde und nur ein Schachzug der Konkurrenz sei, nicht von den Microsoft-Konsumenten gewünscht. Später kam unter anderem durch einen Bericht der New York Times heraus, dass Microsoft der größte Geldgeber des Instituts war und den vollen Preis der Anzeigen bezahlt hatte.